Microsoft разработала свой собственный чип искусственного интеллекта, Azure Maia AI, предназначенный для обучения больших языковых моделей, что позволяет компании избежать зависимости от графических процессоров Nvidia. Кроме того, она создала процессор Azure Cobalt на базе Arm для облачных рабочих нагрузок. Оба чипа предназначены для центров обработки данных Azure и подготавливают компанию к будущему, наполненному искусственным интеллектом.

Чип Azure Maia AI и процессор Azure Cobalt будут доступны с 2024 года, учитывая повышенный интерес к графическим процессорам Nvidia H100 в текущем году. Эти процессоры широко используются для обучения и работы с инструментами генерации изображений и языковыми моделями, и их спрос настолько высок, что цены на них на eBay превысили 40 000 долларов.

Новые чипы созданы Microsoft самостоятельно, а также был пересмотрен стек облачных серверов для оптимизации производительности, мощности и стоимости.

Процессор Azure Cobalt, который является 128-ядерным чипом, созданным на основе CSS-дизайна Arm Neoverse, предназначен для поддержки общих облачных служб в Azure. В настоящее время его тестируют на рабочих нагрузках, таких как Microsoft Teams и SQL-сервер, с планами предоставить клиентам виртуальные машины для различных рабочих задач в следующем году.

Что касается ускорителя искусственного интеллекта Maia 100, он предназначен для выполнения облачных рабочих задач искусственного интеллекта, таких как обучение больших языковых моделей и логический вывод. Он будет использоваться для обработки некоторых из самых крупных рабочих задач искусственного интеллекта в Azure, включая партнерство с OpenAI. Maia 100, созданный по 5-нанометровому техпроцессу TSMC, имеет 105 миллиардов транзисторов и поддерживает суб8-битные типы данных MX, что ускоряет обучение моделей и время вывода.

Microsoft участвует в стандартизации форматов данных для моделей искусственного интеллекта вместе с другими компаниями, такими как AMD, Arm, Intel, Meta, Nvidia и Qualcomm. Совместно с Open Compute Project (OCP) они адаптируют системы к потребностям искусственного интеллекта.

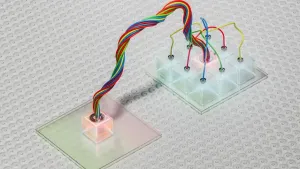

Эти инновации помогут Microsoft быстрее развертывать серверы искусственного интеллекта, не освобождая для них место в центрах обработки данных. Серверные платы Maia будут размещаться в уникальной стойке, дополненной жидкостным охладителем, что способствует эффективному охлаждению чипов Maia. Maia 100 в настоящее время находится на этапе тестирования на GPT 3.5 Turbo для различных рабочих задач, таких как ChatGPT, Bing AI и GitHub Copilot.