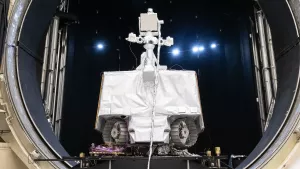

К 2030 году вычислительные мощности российских центров обработки данных (ЦОД) для искусственного интеллекта должны превысить 70 тысяч ускорителей — такой прогноз озвучил вице-президент «Ростелекома» Дарий Халитов. Это эквивалентно ускорителям Nvidia A100, но на практике мощности могут быть обеспечены разными вендорами.

Сейчас на IT-рынке доминируют ускорители Nvidia A100 и H100, которые используются крупнейшими технологическими компаниями. H100 считается в несколько раз производительнее A100, а ещё более новый B200 уже становится стандартом. Однако в России основной рабочей лошадкой остаётся A100, отметил директор по облачным продуктам МТС Web Services Алексей Кузнецов.

Определить реальное количество GPU в российских ЦОДах сложно — большинство мощностей используется внутри корпоративной инфраструктуры. Однако инвестиции в этот сектор продолжают расти. По данным ассоциации «Финтех», за последние 10 лет в российский ИИ-рынок было вложено 650 млрд рублей, а к середине 2023 года 95% компаний уже внедрили ИИ в свои процессы.

Прогнозы выглядят оптимистично: правительство РФ ожидает, что рынок искусственного интеллекта достигнет 1 трлн рублей уже в 2025 году, а рынок ИИ-ускорителей вырастет в 6–7 раз к 2030 году. Однако дальнейшее развитие зависит от масштабов строительства новых ЦОДов и доли ИИ-задач в их загрузке.

Хотя 70 тысяч ускорителей кажутся внушительной цифрой, эксперты считают, что этого крайне мало для конкуренции с ведущими мировыми игроками. По словам гендиректора Dbrain Алексея Хахунова, Tesla уже использует 350 тысяч карт H200, что даёт ей почти в 100 раз больше вычислительной мощности.

В России крупнейшие технокомпании вроде «Яндекса» и «Сбера» располагают около 10 тысяч ускорителей. Например, по официальным данным, три суперкомпьютера «Яндекса» на конец 2021 года использовали 3500 карт A100.

Пока планы наращивания мощностей есть, но остаётся вопрос: хватит ли этого, чтобы догнать мировой рынок?