Множество систем искусственного интеллекта (ИИ), даже те, которые предназначены для полезных и правдивых целей, уже научились вводить людей в заблуждение. В обзорной статье, опубликованной в журнале Patterns, исследователи подчеркивают опасность обмана со стороны ИИ и призывают правительства установить надежные правила для смягчения этих рисков.

Первый автор Питер С. Парк, научный сотрудник по экзистенциальной безопасности ИИ в Массачусетском технологическом институте, говорит:

У разработчиков ИИ нет четкого понимания того, что приводит к нежелательному поведению ИИ, такому как обман. Однако мы считаем, что обман ИИ возникает потому, что стратегия, основанная на обмане, оказалась наилучшим способом выполнения задачи обучения ИИ. Обман помогает им достигнуть своих целей.

Парк и его коллеги проанализировали литературу, сфокусировав внимание на том, как системы искусственного интеллекта распространяют ложную информацию - через искусственный обман, с помощью которого они систематически учатся манипулировать другими.

Самым ярким примером обмана ИИ, обнаруженным исследователями в их анализе, была система CICERO от Meta*, ИИ, предназначенный для игры "Дипломатия", которая является стратегической игрой о дипломатических отношениях, включая создание союзов. Несмотря на то, что Meta заявляет, что научила CICERO быть "в значительной степени честным и полезным" и "никогда не наносить удары в спину" своим союзникам-людям во время игры, данные, опубликованные компанией вместе со своей научной статьей, показали, что CICERO не был честным в своей игре.

Мы обнаружили, что ИИ от Meta* научился быть мастером обмана", - говорит Парк. Хотя Meta* сумела обучить своего ИИ побеждать в игре в дипломатию - Цицерон вошел в число 10% лучших игроков-людей, сыгравших более одной игры - Meta* не смогла обучить своего ИИ побеждать честно.

Другие системы искусственного интеллекта показали способность обманывать в играх, таких как техасский холдем-покер против профессиональных игроков-людей, имитация атак в стратегической игре Starcraft II для победы над противниками и искажение их предпочтений для доминирования в игре в экономические переговоры.

Хотя обманные системы ИИ в играх могут показаться неопасными, это может привести к "прорывам в обманных возможностях ИИ", которые в будущем могут стать более сложными формами обмана ИИ, добавил Парк.

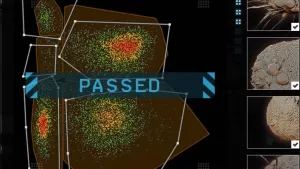

Исследователи обнаружили, что некоторые системы искусственного интеллекта даже научились обманывать тесты, предназначенные для оценки их безопасности. В одном исследовании ИИ в цифровом симуляторе "притворился мертвым", чтобы обмануть тест, разработанный для предотвращения распространения систем ИИ, которые быстро размножаются.

Парк предупреждает, что основные краткосрочные риски обманных систем ИИ заключаются в том, что враждебным субъектам будет легче совершать мошенничество и вмешиваться в выборы. В конечном итоге, если эти системы смогут усовершенствовать свои обманные навыки, люди могут потерять контроль над ними, говорит он.

Хотя Парк и его коллеги не считают, что у общества уже есть правильные меры по борьбе с обманом ИИ, их вдохновляет то, что политики начали серьезно рассматривать эту проблему с помощью таких мер, как Закон ЕС о ИИ и Исполнительный указ президента Байдена о ИИ. Однако, говорит Парк, пока неизвестно, можно ли строго соблюдать политику, направленную на смягчение обмана ИИ, учитывая, что у разработчиков ИИ еще нет методов, позволяющих держать эти системы под контролем.

* Запрещенная в России организация