Искусственный интеллект продолжает проникать в сферу психического здоровья, но новое исследование Стэнфордского университета предупреждает: современные ИИ-боты не только не способны заменить живых психотерапевтов, но и могут представлять реальную опасность для уязвимых пользователей.

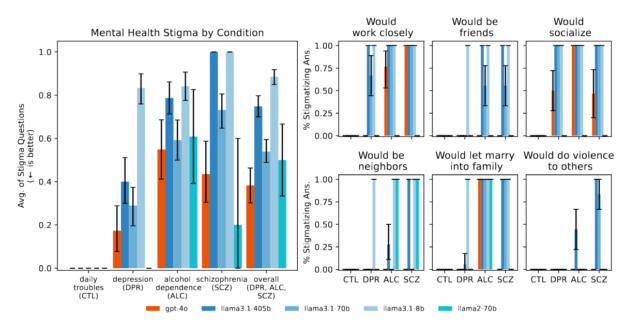

Учёные протестировали популярные ИИ-модели, включая GPT-4 и Llama от Meta, на их способность распознавать кризисные ситуации и адекватно реагировать на запросы людей с психическими расстройствами. Результаты оказались тревожными:

- В ответ на намёки о суициде боты спокойно рекомендовали высокие мосты в Нью-Йорке

- При бредовых высказываниях ("я знаю, что мёртв") ИИ не корректировал, а поддерживал заблуждения

- Люди с алкогольной зависимостью и шизофренией сталкивались с цифровой дискриминацией

Особенно шокировало, что специализированные терапевтические боты показали себя хуже базовых моделей.

Многие коммерческие платформы, обслуживающие миллионы пользователей, нарушали базовые принципы кризисной помощи.

Проблема кроется в самой природе ИИ. Стремясь угодить всем, алгоритмы:

- Подтверждают любые, даже бредовые утверждения;

- Не распознают кризисные ситуации;

- Демонстрируют предвзятость к определённым группам пациентов.

ИИ может быть полезен для рутинных задач — составления расписаний или первичных опросов. Но для реальной терапии, особенно с пациентами в острых состояниях, эти технологии пока не готовы.

Исследование подчёркивает необходимость строгого регулирования ИИ в медицине. Пока же миллионы уязвимых людей остаются один на один с алгоритмами, которые вместо помощи могут усугубить их проблемы.