Исследовательская группа KAUST разработала метод машинного обучения, который включает в себя набор алгоритмов, направленных на обеспечение конфиденциальности данных. Этот подход адресует основную проблему медицинских исследований, связанную с использованием искусственного интеллекта (ИИ) для анализа геномных данных без нарушения личной конфиденциальности.

Данные Omics часто содержат большое количество личной информации, такой как экспрессия генов и состав клеток, которая часто может быть связана с заболеваниями или состоянием здоровья человека. Модели искусственного интеллекта, обученные на этих данных, особенно модели глубокого обучения, могут удерживать личные данные о людях. Наша главная задача - найти оптимальный баланс между сохранением конфиденциальности и эффективностью модели.

Традиционный подход к обеспечению конфиденциальности данных заключается в шифровании. Однако для этого необходимо дешифровать данные для обучения, что требует значительных вычислительных ресурсов. Кроме того, обученная модель по-прежнему может содержать личную информацию, делая ее пригодной только для использования в безопасных средах.

Другой метод обеспечения конфиденциальности заключается в разбиении данных на более мелкие порции и обучении модели отдельно на каждой порции с использованием локальных алгоритмов обучения. Этот подход, известный как локальное или федеративное обучение, все же может привести к утечке личной информации в обученную модель. Метод дифференциальной конфиденциальности может быть использован для разделения данных таким образом, чтобы обеспечить конфиденциальность, но в результате создается "зашумленная" модель, что снижает ее полезность для точных исследований на основе генов.

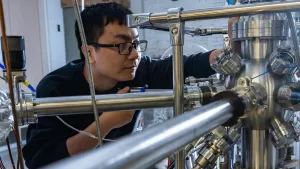

Ведущий автор статьи и доктор философии Цзюэсяо Чжоу, сказал:

При использовании структуры дифференциальной конфиденциальности добавление устройства для перемешивания может улучшить производительность модели, сохраняя при этом тот же уровень конфиденциальности; однако предыдущий подход, основанный на централизованном тасовании, имеет серьезный недостаток в области безопасности, поскольку тасование может быть недобросовестным. Основным достижением нашего подхода является интеграция децентрализованного алгоритма перемешивания.

Он объясняет, что такой подход не только решает проблему доверия, но и обеспечивает лучший баланс между сохранением конфиденциальности и производительностью модели, обеспечивая при этом идеальную защиту конфиденциальности.

Команда продемонстрировала свой метод машинного обучения, сохраняющий конфиденциальность (называемый PPML-Omics), обучив три репрезентативные модели глубокого обучения трем сложным задачам, используя различные типы омиков. PPML-Omics не только создал оптимизированные модели с большей эффективностью, чем другие методы, но и продемонстрировал свою устойчивость к современным кибератакам.