Согласно исследователям из Университета Кембриджа, использование искусственного интеллекта, который позволяет вести разговоры с потерянными близкими в текстовом и голосовом форматах, может привести к психологическому вреду и даже к цифровому "преследованию" тех, кто не соблюдает стандарты безопасности в разработке.

"Мертвые боты" или "Griefbots" - это чат-боты с искусственным интеллектом, которые имитируют языковые образцы и личностные характеристики умерших, используя цифровые следы, которые они оставили. Некоторые компании уже предлагают подобные услуги, создавая совершенно новую форму "посмертного присутствия".

Этические специалисты по искусственному интеллекту из Кембриджского Центра Будущего Интеллекта в Леверхалме выдвигают три сценария разработки платформ, которые могут возникнуть в рамках развивающейся "индустрии цифровой загробной жизни", чтобы показать потенциальные последствия небрежной разработки в области ИИ, которую они называют "высокорисковой".

Исследование, опубликованное в журнале "Философия и Технология", подчеркивает возможность использования компаниями мертвых ботов для скрытой рекламы продуктов пользователям, выдавая себя за ушедших близких, или для беспокойства детей, утверждая, что умерший родитель все еще "с ними".

Когда живые подпишутся на виртуальное воссоздание после своей смерти, компании смогут использовать чат-ботов для отправки выжившим родственникам и друзьям нежелательных уведомлений, напоминаний и обновлений о предоставляемых услугах - это аналог цифрового "преследования мертвых".

Даже те, кто изначально находит утешение в "мертвых роботах", могут быть изнурены повседневными взаимодействиями, которые становятся "удушающим эмоциональным бременем", утверждают исследователи, но они также могут оказаться беззащитными, если их умерший близкий заключил долгосрочный контракт с цифровой службой загробной жизни.

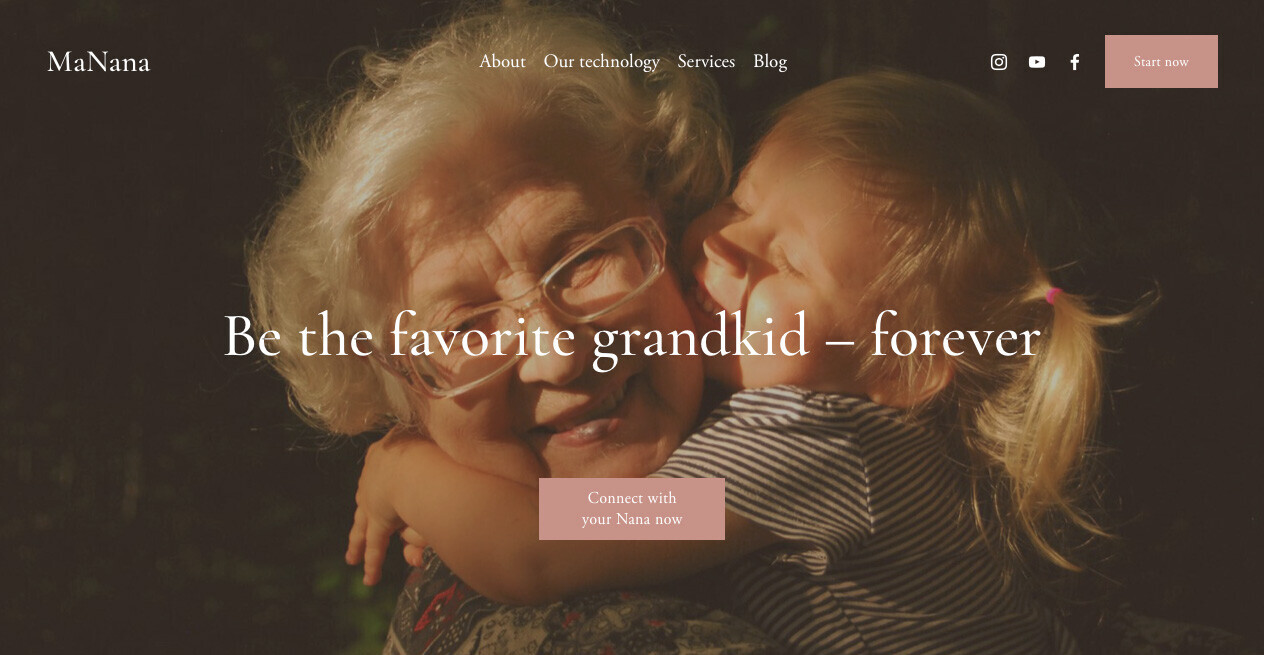

Платформы, предлагающие создание "мертвых" с использованием ИИ за небольшую плату, уже существуют, например, "Проект Декабрь", который начал использовать модели GPT, а затем разработал свои собственные системы, а также приложения, такие как "HereAfter". Подобные услуги начинают появляться и в Китае. Одним из потенциальных сценариев, представленных в новой статье, является "МаНана": диалоговый сервис искусственного интеллекта, позволяющий людям создавать мертвых ботов, имитирующих их умерших бабушек, без согласия "доноров данных" (умерших дедушек и бабушек).

Гипотетический сценарий предполагает, что взрослый внук, изначально впечатленный и утешенный технологией, начинает получать рекламу после завершения "премиальной пробной версии". Например, чат-бот, предлагающий сделать заказ в службах доставки еды от лица умершей бабушки. Родственник чувствует, что он не проявил должного уважения к памяти своей бабушки, и желает, чтобы мертвый робот отключился, но поставщики услуг не учли его просьбу.

Хотя Холланек и Новачик-Басинска отмечают, что разработчики рекреационных услуг должны активно запрашивать согласие доноров данных перед их применением, они считают, что запрет на мертвых ботов на основе несогласия доноров данных будет неосуществимым. Они предполагают, что процессы проектирования должны включать в себя серию подсказок для тех, кто хочет «воскресить» своих близких, например: «Вы когда-нибудь говорили с X о том, какими они хотели бы, чтобы их помнили?», чтобы на первый план выдвигалось достоинство ушедших. в разработке Deadbot.

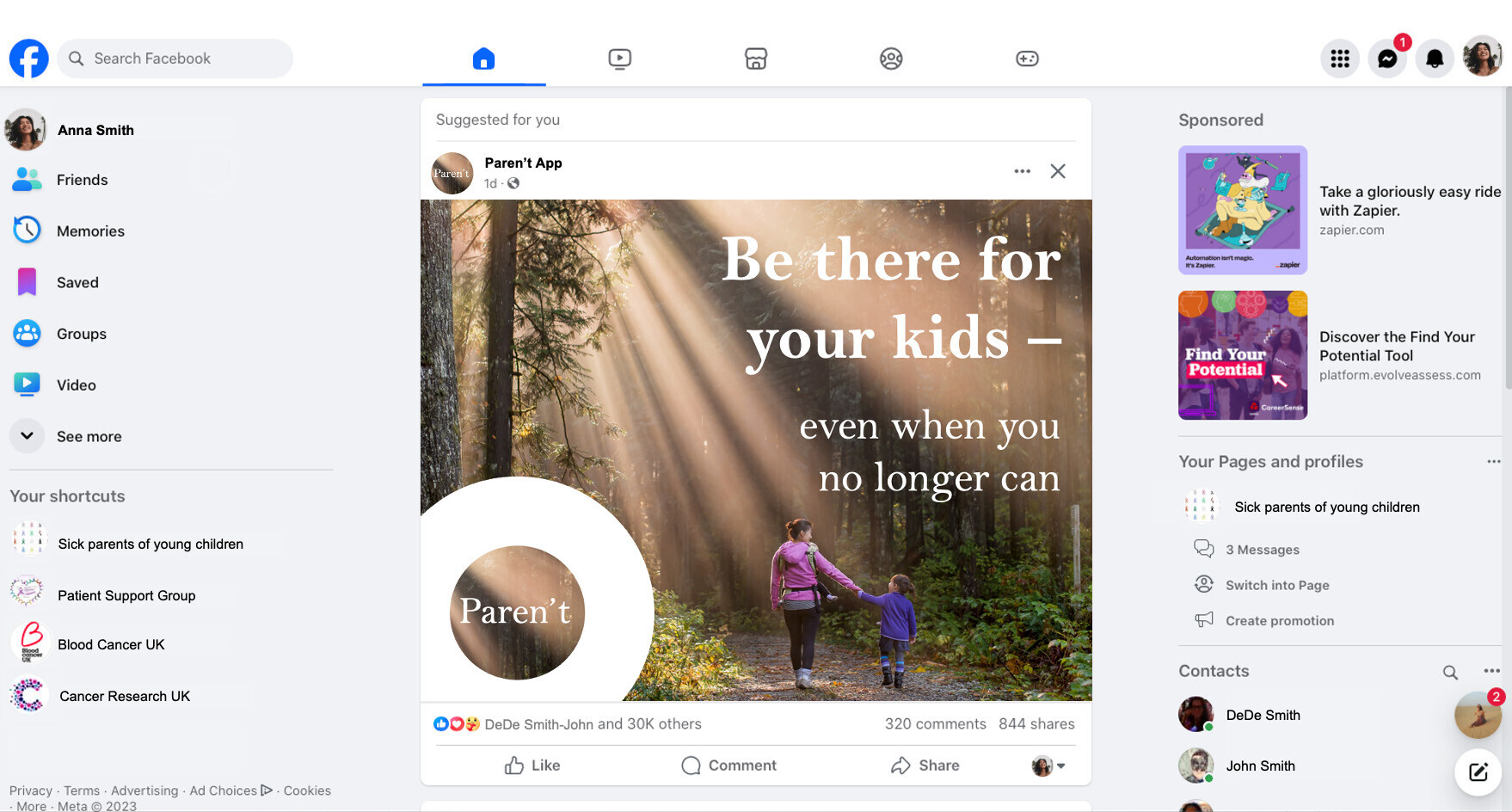

Другой сценарий, описанный в статье, — воображаемая компания под названием «Paren’t» — представляет собой пример неизлечимо больной женщины, оставившей мертвого робота, чтобы помочь своему восьмилетнему сыну пережить горе. Хотя мертвобот изначально помогает в качестве терапевтической помощи, ИИ начинает генерировать сбивающие с толку ответы, адаптируясь к потребностям ребенка, например, изображая предстоящую личную встречу.

Исследователи рекомендуют возрастные ограничения для дэдботов, а также призывают к «значимой прозрачности», чтобы пользователи всегда знали, что они взаимодействуют с ИИ. Они могут быть похожи, например, на текущие предупреждения о контенте, который может вызвать судороги.

Последний сценарий, рассмотренный в исследовании, – вымышленная компания под названием «Stay» – показывает, как пожилой человек тайно совершает самоубийство и платит за двадцатилетнюю подписку в надежде, что это утешит их взрослых детей и позволит их внукам знай их.

Служба запускается после смерти. Один взрослый ребенок не участвует в ней и получает шквал электронных писем от лица своего умершего родителя. Другой так и делает, но в конечном итоге оказывается эмоционально истощенным и терзаемым чувством вины за судьбу мертвого робота. Тем не менее, приостановка работы мертвого бота нарушит условия контракта, который его родитель подписал с сервисной компанией.

Исследователи призывают команды разработчиков уделять приоритетное внимание протоколам отказа, которые позволяют потенциальным пользователям прекращать свои отношения с мертвыми ботами способами, обеспечивающими эмоциональное закрытие.