Генеративные модели искусственного интеллекта, такие как GPT-4 от OpenAI или Stable Diffusion от Stability AI, отлично справляются с созданием текста, кода, изображений и видео. Но их обучение требует огромных объёмов данных, и разработчики уже сталкиваются с проблемами в обеспечении этих ресурсов, что может в скором времени привести к их дефициту.

В условиях недостатка данных идея использования синтетических данных для обучения ИИ становится всё более привлекательной для крупных технологических компаний. Синтезированные данные обходятся дешевле, их можно производить в неограниченных количествах, они представляют меньшие риски для конфиденциальности, например, в медицине, и иногда могут даже улучшить работу моделей.

Но недавнее исследование из Университета Райса выявило, что чрезмерное использование синтетических данных может привести к серьёзным проблемам в развитии будущих поколений ИИ.

Ричард Баранюк, профессор из Университета Райса, объясняет:

Когда синтетические данные используются повторно, возникает своеобразная петля обратной связи, или, как мы это называем, "самопожирающая" петля. Мы много исследовали такие петли и обнаружили, что после нескольких циклов обучения новые модели могут оказаться серьёзно поврежденными. Это явление иногда называют "коллапсом модели", но нам кажется, что термин "расстройство аутофагии модели" (MAD) более точен, по аналогии с коровьим бешенством.

Коровье бешенство — это смертельное заболевание, передающееся через заражённое мясо. Вспышка этого заболевания в 1980-90-х годах была связана с тем, что коров кормили переработанными остатками их же сородичей, отсюда и термин "аутофагия", что в переводе с греческого означает "самоедение".

Исследование под названием "Самопожирающие генеративные модели сходят с ума" стало первым рецензируемым исследованием феномена аутофагии в ИИ и сосредоточено на генеративных моделях, таких как DALL·E 3, Midjourney и Stable Diffusion.

Поскольку интернет является основным источником данных для обучения генеративных моделей, распространение синтетических данных в сети будет создавать самопожирающие циклы с каждым новым поколением моделей. Баранюк и его команда изучили три сценария таких циклов:

- Полностью синтетический цикл: каждое новое поколение модели обучается на полностью синтетических данных, созданных предыдущими поколениями.

- Синтетический цикл с дополнением: модель обучается на смеси синтетических данных и фиксированного набора реальных данных.

- Цикл свежих данных: каждое новое поколение модели использует смесь синтетических данных и нового набора реальных данных.

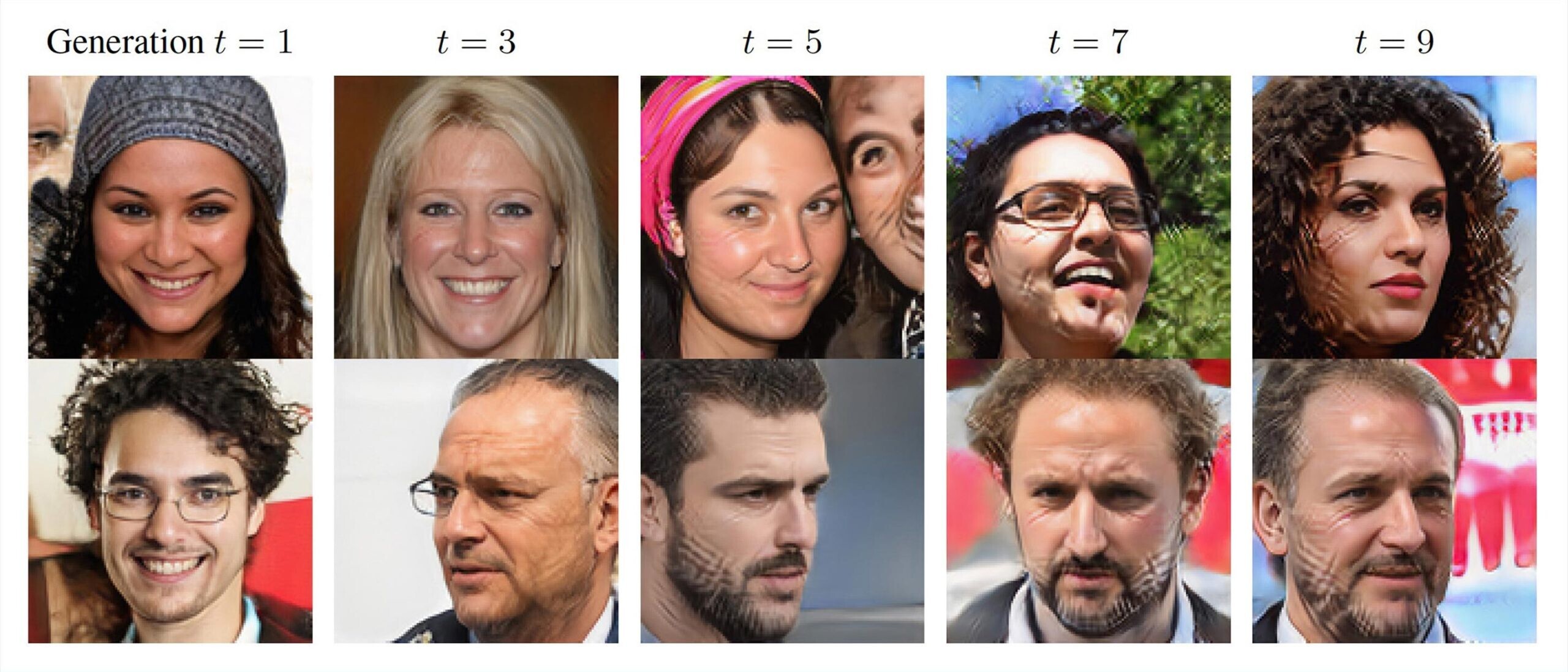

Результаты показали, что без достаточного количества свежих данных модели начинают выдавать всё более искажённые результаты, теряя в качестве и разнообразии. Это означает, что чем больше свежих данных, тем стабильнее и здоровее развивается ИИ.

Сравнение наборов данных, созданных последующими поколениями моделей, показало мрачную картину: изображения человеческих лиц всё больше покрываются странными «шрамами» — так называемыми генеративными артефактами, или начинают напоминать одного и того же человека. Числа в наборах данных превращаются в неразборчивые каракули.

Чтобы сделать исследование более реалистичным, учёные добавили параметр смещения выборки, который учитывает тенденцию пользователей выбирать качество данных, жертвуя их разнообразием. Это приводит к тому, что качество сохраняется дольше, но разнообразие сокращается ещё быстрее.

Если этот процесс не контролировать, MAD может привести к тому, что качество и разнообразие данных в интернете серьёзно пострадают. Даже если этого не случится, неизбежно возникнут другие непредсказуемые последствия от аутофагии ИИ в ближайшем будущем.