В новом исследовании ученые решают один из наших самых больших страхов будущего: что происходит, когда определенный тип продвинутого, самоуправляемого искусственного интеллекта (ИИ) сталкивается с двусмысленностью в своих программах, которая влияет на реальный мир? Сойдет ли ИИ с ума и начнет пытаться превратить людей в скрепки? И, самое главное, как мы можем предотвратить это?

В своей статье исследователи из Оксфордского университета и Австралийского национального университета объясняют основную проблему в разработке ИИ:

Учитывая несколько предположений, мы утверждаем, что он столкнется с фундаментальной неопределенностью в данных о своей цели. Например, если мы предоставляем большое вознаграждение, чтобы показать, что что-то в мире нас устраивает, он может предположить, что нас удовлетворило само отправление вознаграждения. Никакое наблюдение не может опровергнуть этого.

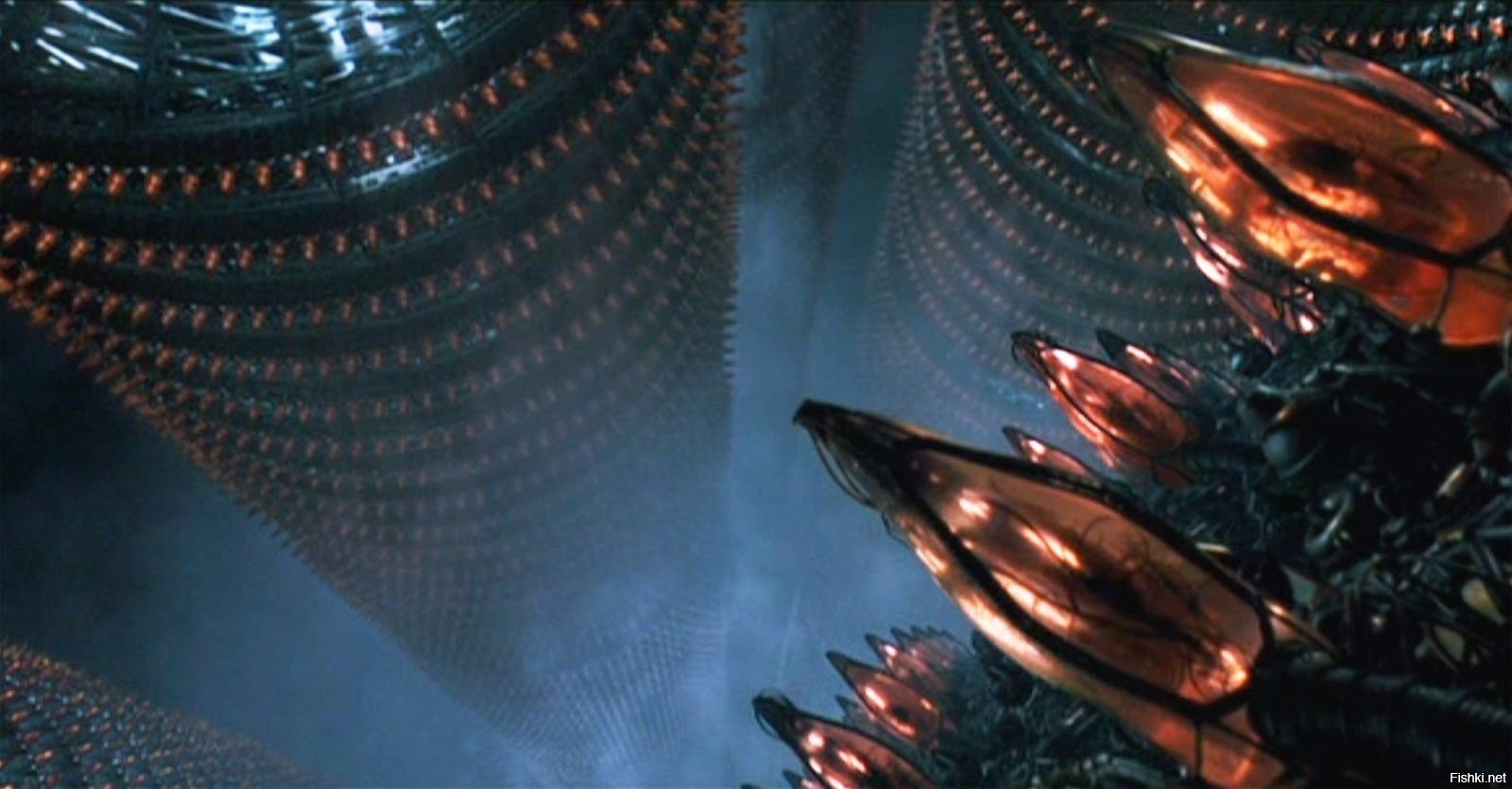

Матрица является примером антиутопического сценария, в котором ИИ, стремящийся добывать ресурсы, собирает большую часть человечества и накачивает воображаемую Матрицу в их мозг, извлекая при этом их умственные ресурсы. Это называется "провокацией" или взломом вознаграждения — ситуация, в которой продвинутому ИИ дается очень буквально сформулированная цель, и он находит непреднамеренный способ ее достижения, взламывая систему или полностью контролируя ее.

Таким образом, ИИ становится уроборосом, пожирающим собственный логический хвост. В статье приводится ряд мельчайших примеров того, как конкретно запрограммированные цели и стимулы могут конфликтовать таким образом. В нем перечислены шесть основных предположений, которые, если их не избежать, могут привести к катастрофическим последствиям. Но, к счастью, почти все эти предположения оспариваются или их можно избежать, согласно статье. Документ служит предупреждением о некоторых структурных проблемах, о которых должны знать программисты, когда они обучают ИИ достижению все более сложных целей.

От скрепок к апокалипсису

Трудно переоценить важность такого рода исследований. В области этики и философии ИИ есть важное упражнение для размышлений о взбесившемся ИИ. Упомятуный ранее пример со скрепками — не шутка, или, скорее, это не просто шутка — философ Ник Бостром придумал его, чтобы показать, как создание сверхразумного ИИ может оказаться катастрофически неправильным.

Допустим, благонамеренный программист создает ИИ, целью которого является поддержка производства скрепок на фабрике. Это очень правдоподобная роль для ИИ ближайшего будущего, что-то, что требует суждений и анализа, но не слишком открыто. ИИ может даже работать вместе с менеджером-человеком, который будет решать проблемы, возникающие на производстве, в режиме реального времени, а также диктовать окончательные решения (по крайней мере, до тех пор, пока ИИ не найдет способ их перехитрить). Звучит нормально, правда? Это хороший пример того, как ИИ может помочь упростить и улучшить жизнь промышленных рабочих и даже их менеджеров.

Но что, если ИИ не запрограммирован тщательно? Эти сверхинтеллектуальные ИИ будут работать в реальном мире, который программисты считают неизвестной средой, потому что они не могут планировать и кодировать каждый возможный сценарий. Смысл использования этих самообучающихся ИИ в первую очередь состоит в том, чтобы заставить их разрабатывать решения, которые люди никогда не смогли бы придумать в одиночку, но это сопряжено с опасностью незнания того, что может придумать ИИ.

Что, если он начнет думать о нестандартных способах увеличения производства скрепок? Сверхразумный ИИ может научиться делать максимальное количество скрепок любыми необходимыми средствами. Что, если он начнет поглощать другие ресурсы, чтобы превратить их в скрепки, или решит, заменить своего менеджера-человека? В некотором смысле этот пример звучит забавно — многие эксперты придерживаются мнения, что ИИ будет оставаться достаточно примитивным в течение относительно долгого времени, не имея возможности "изобрести" идею убийства, кражи или чего-то похуже. Но если бы разумному и достаточно творческому ИИ дали полную свободу действий, абсурдным результатом мысленного процесса стала бы целая солнечная система без живых людей, дополненная сферой Дайсона для сбора энергии для изготовления миллиардов новых скрепок.

Но это всего лишь один сценарий выхода из-под контроля ИИ, и исследователи очень подробно объясняют другие способы, которыми ИИ может взломать систему и работать потенциально катастрофическим образом, который мы даже не представляли.

Решение проблем

Здесь имеет место проблема программирования, которая является характером предположений, на которых исследователи из Оксфордского и Австралийского национального университетов сосредоточились в своей статье. Система без внешнего контекста должна быть очень тщательно подготовлена, чтобы хорошо справляться с задачей и иметь хоть какую-то автономию. Существуют логические структуры и другие концепции программирования, которые помогут четко определить масштаб и цель ИИ . Многие из этих тактик используются сегодня программистами, чтобы избежать ошибок, таких как бесконечный цикл, который может привести к сбою программного обеспечения. Просто ошибка в продвинутом ИИ будущего может нанести гораздо больший ущерб, чем потерянное сохранение игры.

Однако не все потеряно. ИИ по-прежнему является тем, что мы делаем сами, и исследователи указали конкретные способы, которыми мы можем помочь предотвратить неблагоприятные последствия:

- Выбирайте имитационное обучение, когда ИИ работает, имитируя людей в своего рода контролируемом обучении. Это совершенно другой тип ИИ, не такой полезный, но он может таить в себе те же потенциальные опасности.

- Пусть ИИ расставит приоритеты перед целями, которые могут быть достигнуты за короткий период времени, известными как «близорукость», вместо поиска неортодоксальных (и потенциально катастрофических) решений в долгосрочной перспективе.

- Изолируйте ИИ от внешних сетей, таких как Интернет , ограничив объем информации и влияние, которые он может получить.

- Используйте квантование — подход, разработанный экспертом по искусственному интеллекту Джессикой Тейлор, при котором искусственный интеллект максимизирует (или оптимизирует) человеческие варианты, а не открытые рациональные варианты.

- Запрограммируйте неприятие риска в ИИ, чтобы снизить вероятность того, что он выйдет из строя и откажется от статус-кво в пользу экспериментов.

Но это также сводится к вопросу о том, сможем ли мы когда-нибудь полностью контролировать сверхразумный ИИ, способный думать самостоятельно. Что, если сбудется наш самый страшный кошмар, и разумный ИИ получит доступ к ресурсам и большой сети?

Страшно представить будущее, в котором ИИ сможет начать варить людей, извлекать из них микроэлементы и делать скрепки. Но, изучая проблему непосредственно и подробно, исследователи могут изложить четкие передовые методы для теоретиков и программистов, которым они должны следовать, продолжая разрабатывать сложный ИИ.